BIOHAZARD RE:3クリアしました。クリア時間は7時間です。

BIOHAZARD RE:3クリアしました。クリア時間は7時間です。

PSストアのセールにてRACCOON CITY EDITIONを79%offで購入しました。その後PS Plusゲームカタログに来たけどね…

RE:2と同じく、オリジナル版プレイしたの20年くらい前なので内容ほとんど忘れてます。

前作:

・バイオハザードRE:2クリア(ネタバレ)

システム

システムはRE:2とだいたい同じか。グラフィック綺麗で良いよね。

今作でもやられまくって途中で難易度ASSISTED(イージー)に変更しました。そしたらあんまり死なないし弾薬とかも余りまくった。

街中を走り回り、色んな施設にも行ったのにあっさり終わった感じ。どうやらオリジナルから時計塔エリアなどが無くなってるみたい。

ストーリー

1作目の洋館事件で生き残ったジル。

1作目の洋館事件で生き残ったジル。

部屋で寝てたらネメシスに襲撃される。アンブレラ社を告発しようとしたので、暗殺のため送り込まれたらしい。

逃げて外に出ると街はゾンビだらけになっていた。

アンブレラ私設部隊のカルロスに助けられ地下鉄の避難所に案内される。カルロス達はバイオハザードの原因を知らないようで、鉄道を復旧させて市民をラクーンシティから脱出させる計画を立てていた。ジルも手伝うことにする。

変電所に行き地下鉄の電源を復旧させた。しかしネメシスがやってきたので、ジルは囮として逃げ回ることにする。

変電所に行き地下鉄の電源を復旧させた。しかしネメシスがやってきたので、ジルは囮として逃げ回ることにする。

ネメシスほんとしつこい。

途中でガンショップ・ケンドの主人に会い「あっこれRE:2の前日譚なんだ」と今さら気づくw 時系列とか気にせずプレイしてたわ。

何とか撒いて地下鉄に戻ったけど、カルロスとタイレルはバード博士救出任務のため出かけて行きました。ジルはみんなと一緒に電車で脱出。

ここからカルロスパート。

ここからカルロスパート。

警察署入口ではゾンビに襲われるマービン警部補の姿が。まさに前作直前の内容だね。

バード博士を探すため警察署を探索したけど、いや懐かしいね。シャワールームの壁壊したのカルロスだったのかw

ジルパート。

ジルパート。

電車がネメシスの襲撃に遭う。ニコライが車両に鍵をかけたせいで逃げられず、ジル以外全滅してしまう。

しつこく追ってきたネメシスを時計塔前で倒したものの、t-ウイルスに感染して倒れてしまう。

カルロスパート。

カルロスパート。

ジルを見つけ病院に連れて行く。ここでワクチンを探していると、殺されたバード博士の姿があった。ニコライのせいだな。

あとついにこの騒動がアンブレラ社のせいだと知る。ともかく唯一あったワクチンを見つけジルを助けました。

ジルパート。

ジルパート。

数時間後に巡航ミサイルでラクーンシティが爆撃されてしまう。回避のためワクチンを探しに行ったカルロスを追って、アンブレラ社の地下研究施設NEST2に向かう。

ワクチンを作成できたけどニコライに奪われてしまう。

ワクチンを作成できたけどニコライに奪われてしまう。

ニコライは競合他社から送られたスパイで、お金のためにt-ウイルスや生物兵器の調査をしていた。

山のような巨体になったネメシス。

山のような巨体になったネメシス。

燃やしても酸で溶かしても死ななかったけど、レールガンを使って今度こそようやく倒せました。

ニコライを追いかけてカルロスと一緒に戦い倒します。ワクチンのビンは割られちゃったけど、ニコライを残してヘリコプターで脱出。間一髪で巡航ミサイル爆撃に巻き込まれずに済みました。

メデタシメデタシ。

しかし、生き残って助けを待っていた人もたくさんいただろうに、巡航ミサイルでみんな死んじゃったんだろうなあ… なんて考えたり。

まとめ

数日でクリアしてしまい物足りない気はしたけどまあ楽しかったです。

少し前にnano-bananaという謎のAIモデルが話題になりましたが、その正体はGoogleのGemini 2.5 Flash Image Previewでした。

少し前にnano-bananaという謎のAIモデルが話題になりましたが、その正体はGoogleのGemini 2.5 Flash Image Previewでした。 「メイド服にして」と指示したら同じ絵柄と構図で衣装だけ変わりました。

「メイド服にして」と指示したら同じ絵柄と構図で衣装だけ変わりました。

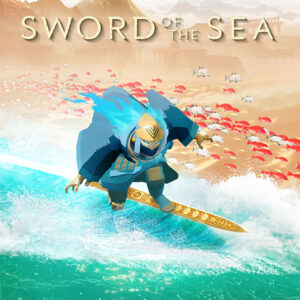

Sword of the Sea

Sword of the Sea

BIOHAZARD RE:3

BIOHAZARD RE:3

ぎゃる☆がん だぶるぴーす

ぎゃる☆がん だぶるぴーす