動かすのはLLM(大規模言語モデル)、つまりテキスト生成AIです。

ツール選定

まずはPCスペックの確認。それなりに良いやつなので問題ないはず。

CPU:Core Ultra7 265KF

RAM:32GB

GPU:RTX5070Ti (VRAM 16GB)

次はクライアント。LM Studioを使うことにしました。一番有名っぽいので。

最後はモデル。無難にGoogleのGemma3にしました。

初期設定

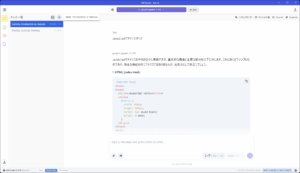

LM Studioをインストールして起動。モデルもこのクライアントからダウンロード出来るので、すぐ使用できるようになりました。簡単すぎて驚いた。

画像生成AIは設定面倒なのに、LLMはこんな簡単に出来るんだね。

動かしてみた

Gemma-3-12B。テキスト投げたら一瞬で返答が来る。これは良いね。モデルサイズ8.15GBでVRAMに丸ごと乗るから軽い。

Gemma-3-12B。テキスト投げたら一瞬で返答が来る。これは良いね。モデルサイズ8.15GBでVRAMに丸ごと乗るから軽い。

Gemma-3-27B。モデルサイズ16.43GBでVRAMに乗り切らず結構重たい。

ちなみに12B, 27Bというのはそれぞれパラメータ数が120億, 270億という意味です。そして12Bが速度と精度のバランスが取れたモデルとのこと。

この2モデル試していましたが、正直あまり性能差は感じられませんでした。「JavaScriptでテトリス作って」と指示したら、どちらも動かないコード出してきたし。

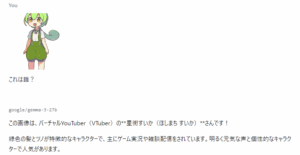

ずんだもんの画像見せたら「星街すいかさんです!」と自信満々に答えられて吹いた。

ずんだもんの画像見せたら「星街すいかさんです!」と自信満々に答えられて吹いた。

誰だよw

調べたら12BがGPT-3.5くらい、27BがGPT-4くらいの性能とのことでした。なるほど、2年以上前のChatGPTと考えれば納得だ。

ともかく動くようになったので、なりきりチャットとかさせてみようかなw あと外部ツールから呼び出したり出来るのかな? 色々いじってみよう。

まとめ

ちょっとした会話なら問題ないけど、知識が必要なことは厳しいなあと思いました。ローカルで動くこと自体は凄いんだけどね。

そのうち他のモデルも試してみます。

数日使ってみて

12Bで近所の公園について質問したら正しい返答が来て驚いた。たった8GBなのにそんなローカルな情報まで網羅してるのか。デタラメも多いけどね(汗)

12Bと27Bでは日本語の表現が段違いだった。しかし27BはVRAM16GBだと200~300トークンまでしか対応できないらしい。試した限りでは2000トークンくらいで同じ返答繰り返すようになり、まともに動作しなくなる。残念…

APIはOpenAI準拠で使えました。既にLLM+画像生成AI+音声生成AIを繋ぎ合わせてる人とかいたけど、いろんなことが出来そうだ。

他のモデルもためしてみたけど、今のところGemma3が一番しっくり来るな。Qwen3は推論内容が見えて楽しいんだけど、見当違いの返答が多くて。

コメント